DeepSeek

G pt 4 all Ai

满足你对卓越的渴望,共创无限可能! DeepSeek智能无限,点燃创意火花!它不仅是工具,更是灵感源泉,解锁潜能,让未来触手可及。每一次交互,都激发无限想象,释放内心激情。想要突破常规,拥抱更广阔的世界?

7

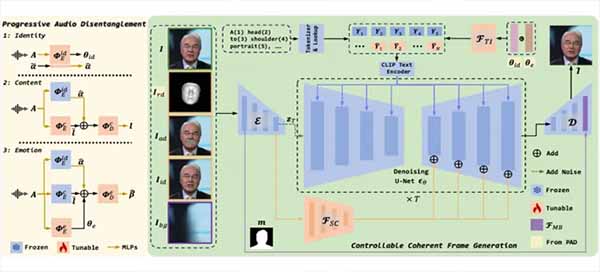

Sonic

8

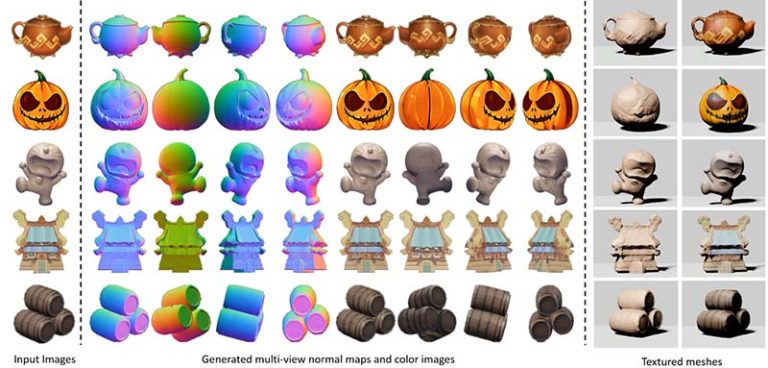

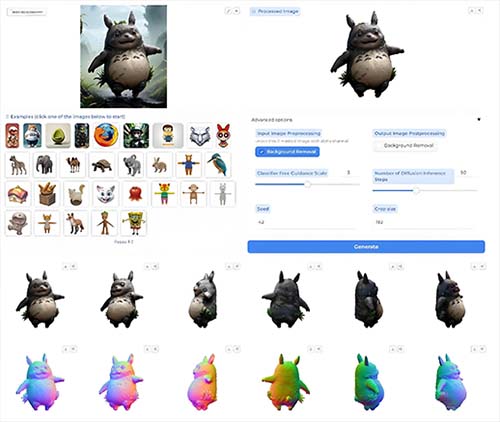

3DModelBox

9

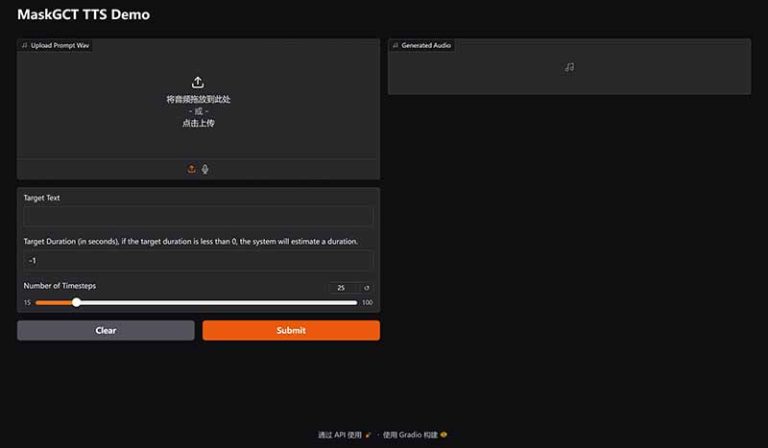

Applio

10

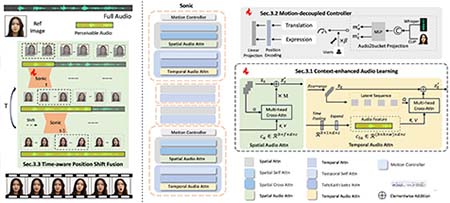

LatentSync2MX

11

MMAudio

12

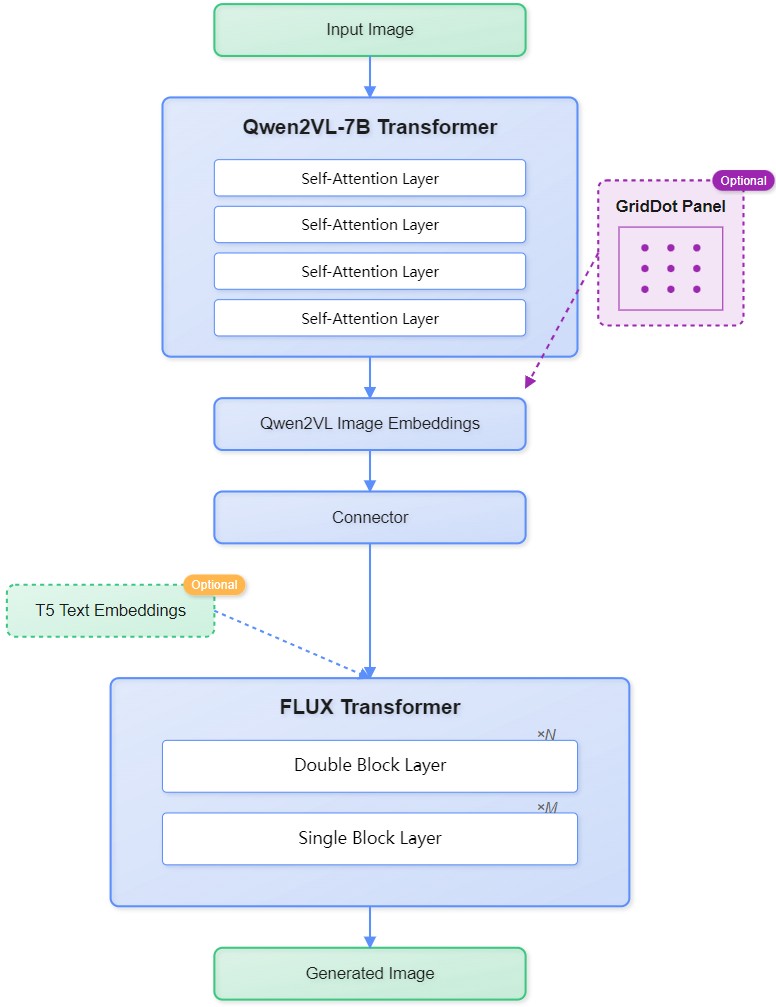

Pyramid-Flow

金字塔流匹配算法:将视频生成分解为多分辨率阶段(低→高),通过插值优化计算效率,token量仅为传统扩散模型的1/4147。

统一优化框架:采用单一DiT(Diffusion Transformer)端到端训练,大幅缩短训练周期(A100 GPU仅20,700小时)